Ich beschäftige mich schon lange mit Videobearbeitung, aber die Tongestaltung war für mich immer die größte Herausforderung. Ich kann stundenlang nach dem passenden Soundeffekt suchen – sei es ein dramatisches Rauschen, ein knisterndes Kaminfeuer oder ein sanfter Hintergrundton – und finde trotzdem nicht den richtigen. Die meisten Soundbibliotheken sind überteuert, zu einfach oder einfach nicht passend.

Letzte Woche arbeitete ich an einem kurzen Reisevideo. Die Bilder waren fertig – Farben, Schnitte und Übergänge sahen gut aus –, aber als ich es mir ansah, wirkte es flach. Es fehlte ihm an Atmosphäre. Da wurde mir klar: Ich brauchte nicht nur Hintergrundgeräusche, sondern einen Ton, der die Geschichte untermalte.

Also begann ich nach einem KI-Soundgenerator zu suchen, der tatsächlich verstehen konnte, was ich verlangte, anstatt mir zufällige Soundeffekte zu liefern.

Folgendes wollte ich:

Nachdem ich verschiedene Tools getestet hatte, stellte ich fest, dass die meisten sogenannten „KI“-Plattformen lediglich auf Standard-Soundbibliotheken zurückgriffen. Ein Tool stach jedoch heraus: Es generierte den Sound tatsächlich allein aus der Eingabeaufforderung. Als ich „alte Metalltür, die sich langsam in einem dunklen Flur öffnet“ eingab, erzeugte es einen Sound, der sich realistisch und detailliert anfühlte und perfekt zur Szene passte.

Zum ersten Mal musste ich nicht mehr darum kämpfen, den passenden Ton für mein Video zu finden – ich konnte den Ton an meine Geschichte anpassen.

Anstatt stundenlang in Klangbibliotheken zu suchen, beschreibe ich jetzt einfach den gewünschten Klang – zum Beispiel „sanfter Regen, der abends gegen Glas prasselt“ – und die KI erzeugt ihn in Sekundenschnelle.

Ich habe beschlossen, die besten Tools für mich auszuwählen und sie in diesem Artikel vorzustellen. Dazu habe ich meine Kollegen vom das FixThePhoto-Team um Unterstützung gebeten. Wir haben verschiedene Projekte ausgewählt – einige aus meiner beruflichen Tätigkeit und einige Lifestyle-Videos für soziale Medien, die von meinen Kollegen erstellt wurden.

Wir notierten, was jedes Projekt benötigte, und begannen, verschiedene Tongeneratoren zu erkunden. Wir durchsuchten Foren, sahen uns Empfehlungen an und testeten dann jedes Tool.

Guter Videoton entsteht nicht am Computer. Er beginnt im Kopf. Zuerst einmal Finde die emotionale Komponente deiner Geschichte heraus Jede Szene hat eine andere Atmosphäre, mal ruhig, mal energiegeladen, mal geheimnisvoll. Wenn du weißt, welche Stimmung du erzeugen willst, kannst du den Sound gezielt darauf ausrichten, anstatt ihn erst im Nachhinein hinzuzufügen.

Dank KI ist das Erstellen von Sound für Ihre Videos jetzt einfacher. Sie müssen nicht mehr endlose Soundbibliotheken durchsuchen. Beschreiben Sie die Emotion, die Szene oder die Atmosphäre, die Sie erzeugen möchten. Die KI erstellt dann den passenden Sound für Sie. Je genauer Ihre Beschreibung ist, desto besser sind die Ergebnisse.

Die gleiche Regel gilt auch für Stimmen. Wähle eine Stimme Die Stimme passt perfekt zum Stil Ihres Videos: eine kräftige, klare Stimme für ein Tutorial, eine sanfte, ruhige Stimme für eine traurige Geschichte oder eine energiegeladene Stimme für einen rasanten Clip. Dank KI klingen diese Stimmen jetzt natürlich und authentisch und harmonieren perfekt mit Ihrem Video.

Nachdem Voiceover und Soundeffekte fertiggestellt sind, beginnt die eigentliche Arbeit beim Schnitt. Durch Anpassen von Lautstärke, Timing und der Abstimmung der Töne auf das Video wirkt alles natürlich und lebendig. kleine Details - leichte Hintergrundgeräusche, ein sanftes Echo oder leichte EQ-Anpassungen können dafür sorgen, dass sich der Ton so anfühlt, als gehöre er wirklich zur Szene.

Am Ende kommt es bei einem guten Klang nicht nur auf die verwendeten Werkzeuge an. Es geht darum, die Stimmung und die Botschaft Ihres Videos zu kennen. Sobald Sie die Geschichte und das Gefühl, das Sie vermitteln möchten, verstanden haben, hilft Ihnen KI einfach dabei, diese auszudrücken. Das Sounddesign wird so zu einem nahtlosen Bestandteil des Erzählprozesses und ist kein technisches Problem mehr.

| DOS | Was man nicht tun sollte |

|---|---|

|

✔️ Legen Sie die Stimmung und das Gefühl Ihres Videos fest, bevor Sie den Ton erstellen.

|

❌ Beginnen Sie mit der Audioerzeugung, ohne zu wissen, welche Atmosphäre Sie erzeugen möchten.

|

|

✔️ Verfassen detaillierte Aufgabenstellungen mit klaren Beschreibungen.

|

❌ Verwenden keine kurzen oder vagen Anweisungen wie „Hintergrundmusik“ oder „Stimme“.

|

|

✔️ Wählen einen Sprachstil und ein Sprechtempo, die zu den Bildern und der Botschaft passen.

|

❌ Verwenden Sie für jedes Projekt den gleichen Tonfall.

|

|

✔️ Passen beim Bearbeiten von Tonaufnahmen Timing, Lautstärke und Überblendung an.

|

❌ Fügen keine Töne ein, ohne sie mit dem Video zu synchronisieren.

|

|

✔️ Fügen leise Umgebungsgeräusche hinzu, um die Szene realistischer wirken zu lassen.

|

❌ Der Klang sollte sich weder leer noch zu sauber anfühlen.

|

|

✔️ Nutzen Sie als Werkzeug zur Unterstützung Ihrer Kreativität.

|

❌ Erwarten Sie, dass die KI die gesamte kreative Arbeit für Sie erledigt.

|

Als ich Adobe Firefly-Video zum ersten Mal öffnete, war ich mir nicht sicher, was mich erwarten würde. Ich hatte zwar schon viel darüber gehört, aber nie wirklich erkundet, was es alles kann – vor allem, weil ich normalerweise manuell in Stockbibliotheken nach Sounds und Voiceovers suchte.

Ich entschied mich, es an einem Projekt auszuprobieren, das mir Schwierigkeiten bereitet hatte: eine dramatische Szene, in der eine Person bei Sonnenuntergang durch eine leere Stadt geht. Normalerweise würde ich lange in Soundbibliotheken nach Schritten, Wind und sanften Stadtgeräuschen suchen – und selbst dann würde ich wahrscheinlich etwas finden, das sich nicht ganz stimmig anfühlt.

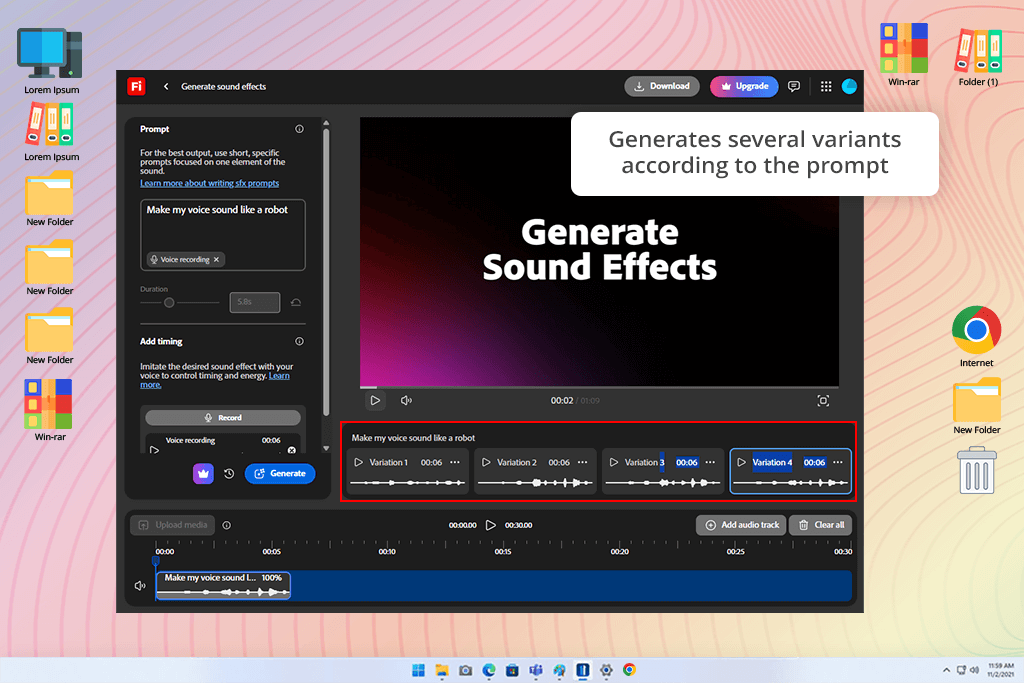

Ich gab eine detaillierte Anweisung in diesen Soundgenerator ein: „Hallende Schritte in einer ruhigen Stadtstraße bei Sonnenuntergang, sanfter Wind, leise Sirenen in der Ferne, filmische Stimmung.“ Innerhalb weniger Sekunden generierte er mehrere Klangversionen. Die Qualität überraschte mich – die Schritte hatten ein realistisches Tempo und Gewicht, der Wind schuf Atmosphäre, ohne etwas zu übertönen, und die fernen Sirenen erzeugten eine subtile Spannung. Das Ergebnis wirkte vielschichtig und nuanciert, nicht wie ein kurzer, sich ständig wiederholender Ton.

Dann habe ich überprüft, wie stark ich den Ton anpassen kann. Ich konnte die Stärke des Windgeräusches in dieser kostenlosen Adobe-Software verändern, Echo hinzufügen oder reduzieren, um die Schritte näher oder weiter entfernt klingen zu lassen, und sogar verschiedene Teile des Audiomixes trennen.

Ich habe den von Firefly erzeugten Sound direkt in meine Video-Timeline eingefügt. Er passte perfekt zum Bildmaterial, und die Szene wirkte sofort realistischer. Dank der Benutzeroberfläche war es einfach, verschiedene Versionen auszuprobieren – ich konnte Sounds generieren, anhören, anpassen und austauschen, ohne meinen Bearbeitungsbereich zu verlassen.

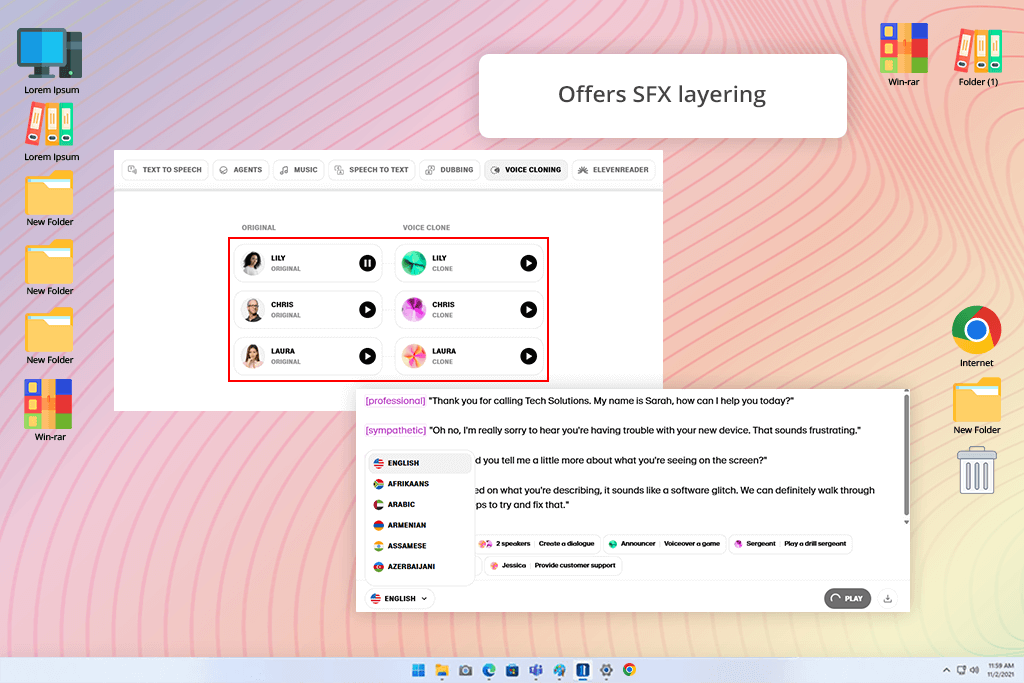

Ich testete ElevenLabs an einer Szene, die für eine kurze Dokumentation einen Sprechertext benötigte. Ich verfasste eine kurze Anweisung, die den gewünschten Tonfall beschrieb: ruhig, klar und gleichmäßig. Innerhalb weniger Sekunden generierte ElevenLabs ein Voiceover, das sehr natürlich klang – Rhythmus, Betonung und sogar die leisen Atemzüge wirkten realistisch.

Am meisten beeindruckte mich, wie einfach ich die Sprachdetails anpassen konnte. Ich konnte Geschwindigkeit, Tonfall und Betonung ändern, ohne auf komplizierte Audiobearbeitungssoftware zurückgreifen zu müssen, die ich zuvor verwendet hatte. Für Soundeffekte habe ich beispielsweise Wind und leichten Regen hinzugefügt.

Obwohl ElevenLabs hauptsächlich für Sprachaufnahmen konzipiert ist, passten die erzeugten Umgebungsgeräusche gut zu meinem Video. Insgesamt ist ElevenLabs eine ausgezeichnete Wahl, wenn Ihr Projekt hauptsächlich auf Sprechertexten basiert und Sie bei Bedarf Hintergrundeffekte hinzufügen können.

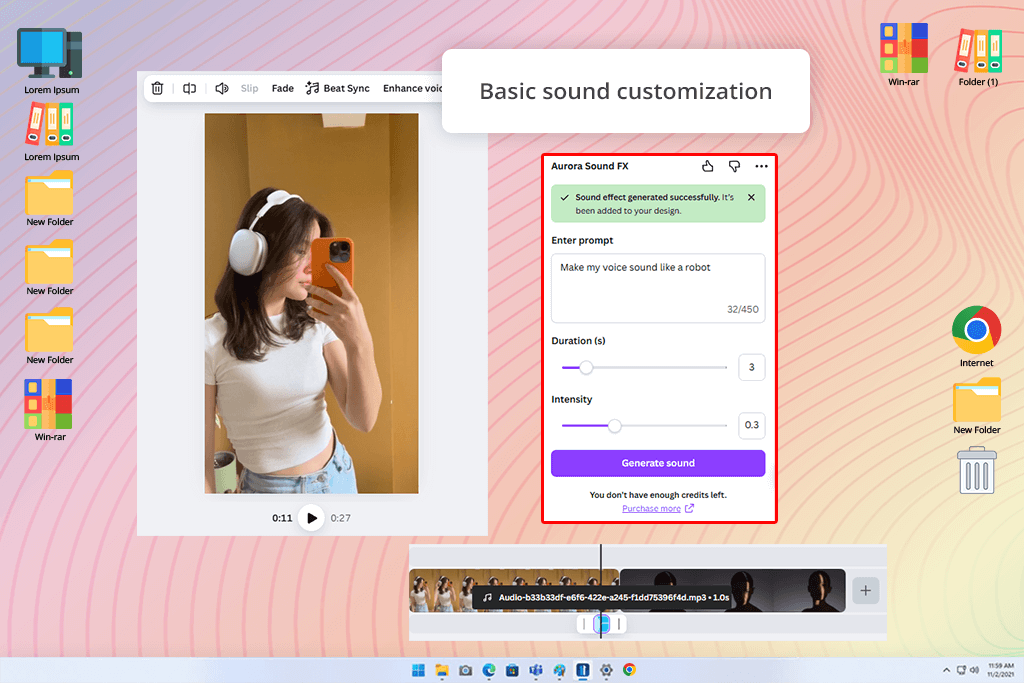

Ich hätte nicht gedacht, dass canva so stark in Sachen Soundgestaltung ist, aber die KI-Audiofunktionen erwiesen sich als sehr benutzerfreundlich. Ich habe einen kurzen Promo-Clip hochgeladen und brauchte dezente Hintergrundmusik – eine sanfte Brise und leises Glockenspiel, um die positive Stimmung zu unterstreichen.

Mit canva konnte ich eine kurze Beschreibung eingeben, und es wurden schnell mehrere Soundoptionen angezeigt, die ich in der Vorschau anhören und direkt auf der Zeitleiste platzieren konnte.

Der größte Vorteil ist die einfache und nahtlose Bedienung. Sie benötigen keinerlei Audiokenntnisse – die KI bietet Ihnen zahlreiche vorgefertigte Soundoptionen, die Sie direkt in Ihr Projekt einfügen können. Das Programm ist nicht für detaillierte Tonbearbeitung konzipiert, sondern für schnelles und komfortables Arbeiten, bei dem der Ton sofort zum Bild passen soll. Ideal für Marketing- und Social-Media-Videos.

Das Beste daran ist, dass alles in einem einzigen Editor erledigt werden kann. Kein Exportieren, kein Wechseln zwischen Apps und keine Verwendung separater KI-Musikgeneratoren Für die schnelle Erstellung von Social-Media-Inhalten ist das unglaublich hilfreich.

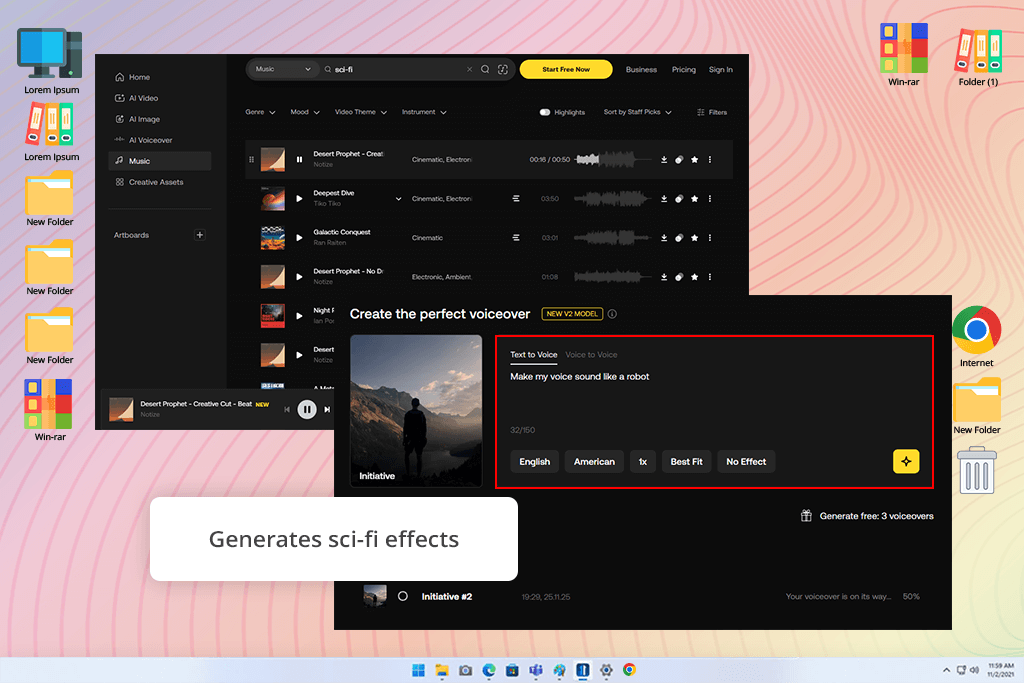

SFX Engine fühlte sich an wie die Verwendung eines professionellen Soundeffektgenerators. Ich habe es ausprobiert, indem ich mehrschichtige Sci-Fi-Sounds erstellt habe – Laserschüsse, Metallaufprallgeräusche und ein leises Raumschiff-Brummen im Hintergrund. Mit dem Tool konnte ich Dinge wie Tonhöhe, Echo und die Position des Klangs im Raum verändern und hatte so eine Kontrolle, die ich normalerweise nur bei vollwertigen DAWs finde

Am meisten beeindruckte die Authentizität der Klänge. Viele KI-Tools erzeugen monotone oder flache Effekte, doch SFX Engine erzeugte einen satten, filmreifen Klang – wie direkt aus einem professionellen Film-Soundtrack.

SFX Engine ist nicht der beste KI-Stimmengenerator für schnelle Social-Media-Clips. Er richtet sich an Kreative wie Filmemacher, Animatoren und Spieleentwickler, die volle Kontrolle und realistischen Sound wünschen. Der Nachteil: Es braucht Zeit zum Erlernen und einen leistungsstarken Computer. Wer jedoch professionellen Sound benötigt, findet hier eines der besten verfügbaren Tools.

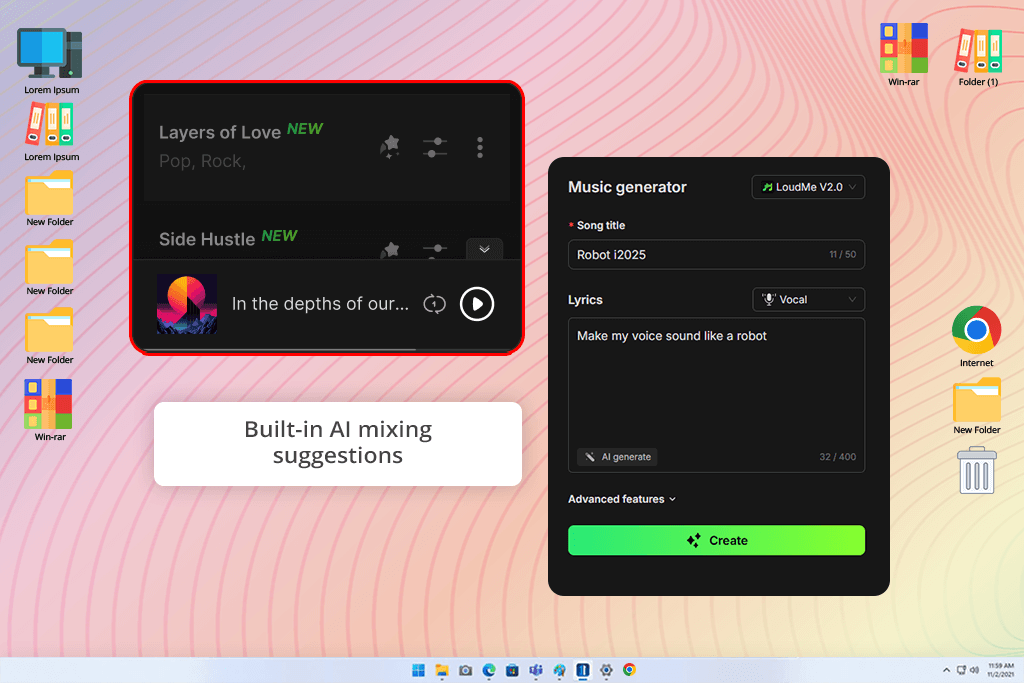

Die Nutzung von LoudMe fühlte sich an, als hätte ich einen Helfer, der die gewünschte Atmosphäre bereits verstand. Ich bearbeitete gerade ein Café-Video und suchte nach Hintergrundgeräuschen, die sich authentisch anfühlten, aber nicht ablenkten – leise Gespräche, Kaffeemaschinen, leises Geschirrklappern.

Ich habe eine Beschreibung der Umgebung eingegeben, und innerhalb weniger Sekunden lieferte mir LoudMe mehrere Versionen zur Auswahl. Jede Version hatte einen anderen Pegel an Hintergrundgeräuschen und einen anderen Ton. Ich wählte diejenige, die am natürlichsten klang, und fügte sie in meinen Schnitt ein – sie passte perfekt, ohne dass weitere Anpassungen nötig waren.

Das Beste daran war, dass diese Voice-Over-Software automatisch die richtige Lautstärkebalance basierend auf dem Ton meines Videos vorschlug. Ich musste Hintergrundgeräusche und Sprache nicht manuell anpassen.

Für detaillierte Tonbearbeitung ist es zwar nicht die fortschrittlichste Option, aber ideal für schnelle, realistische Ergebnisse. Vlogger, Kreative und alle, die schnell arbeiten müssen, profitieren von LoudMe, das eine klare, natürliche Atmosphäre mit minimalem Aufwand erzeugt.

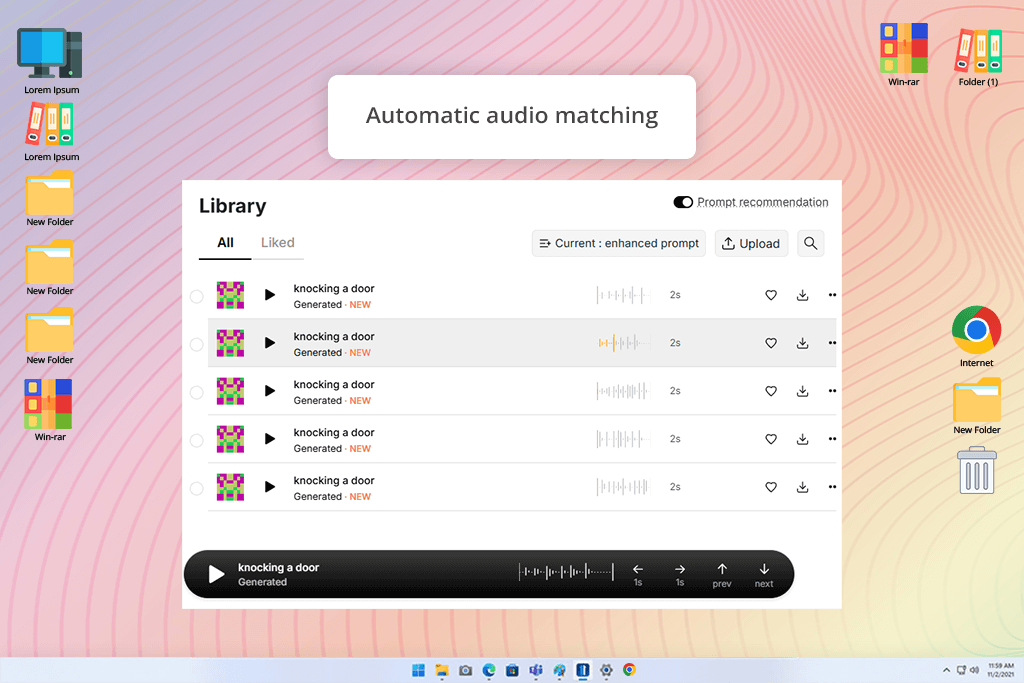

OptimizerAI fiel mir auf, weil es verspricht, automatisch passenden Ton zum Bildmaterial zu erzeugen. Ich wollte herausfinden, ob es tatsächlich ein Video analysieren und einen zur Szene passenden Ton generieren kann. Außerdem las ich in Foren, dass es gut funktioniert, um animierte Stimmen zu erstellen (animierte Stimmen, also wollte ich das auch testen.

Ich habe eine kurze Kampfszene aus einem meiner Projekte hochgeladen – schnelle Schüsse, Schwerthiebe und schwere Schritte. OptimizerAI hat automatisch Timing und Bewegung im Video analysiert. Nachdem ich eine kurze Anweisung wie „intensive mittelalterliche Kampfatmosphäre“ eingegeben hatte, generierte das Programm sofort passende Soundeffekte.

Am meisten überraschte mich, wie die KI die Geräusche selbstständig mit der Handlung synchronisierte – die Schritte passten zur Bewegung, die Zusammenstöße trafen genau auf die Schaukeln, und der Hintergrundhall veränderte sich natürlich. Ich musste kaum etwas anpassen.

KlingAI ist für Kreative gemacht, die sich einen fantasievollen und unwirklichen Klang wünschen. Ich habe diesen KI-Stimmengenerator (3-3-8-Ton) für eine verträumte Animation ausprobiert und brauchte einen weichen, schwebenden Klang. Meine kurze Vorgabe lautete: „Sanfte Glockenklänge mit tiefen, summenden Tönen und langsamen, wellenartigen Impulsen.“

Wenige Sekunden später erzeugte KlingAI Klänge, die fast lebendig wirkten. Sie klangen nicht wie die üblichen Effekte, die man auf typischen lizenzfreien Musikseiten findet. Stattdessen hatten sie Tiefe und Atmosphäre. Ich kombinierte einige der generierten Clips, und das Endergebnis wirkte originell – etwas, das ich mit einer Standard-Soundbibliothek nicht erreichen konnte.

KlingAI ist nicht für natürliche oder realistische Klangumgebungen konzipiert – der Fokus liegt auf ausdrucksstarkem, atmosphärischem Klang. Es eignet sich am besten für künstlerische Intros, Stimmungsübergänge oder Experimentalfilme, bei denen ein emotionaler und unverwechselbarer Klang gewünscht ist.

Der Nachteil ist, dass die Ergebnisse variieren können und man den Vorgang möglicherweise mehrmals wiederholen muss, um das gewünschte Ergebnis zu erzielen. Doch wenn das Ergebnis stimmt, entsteht etwas ganz Besonderes.

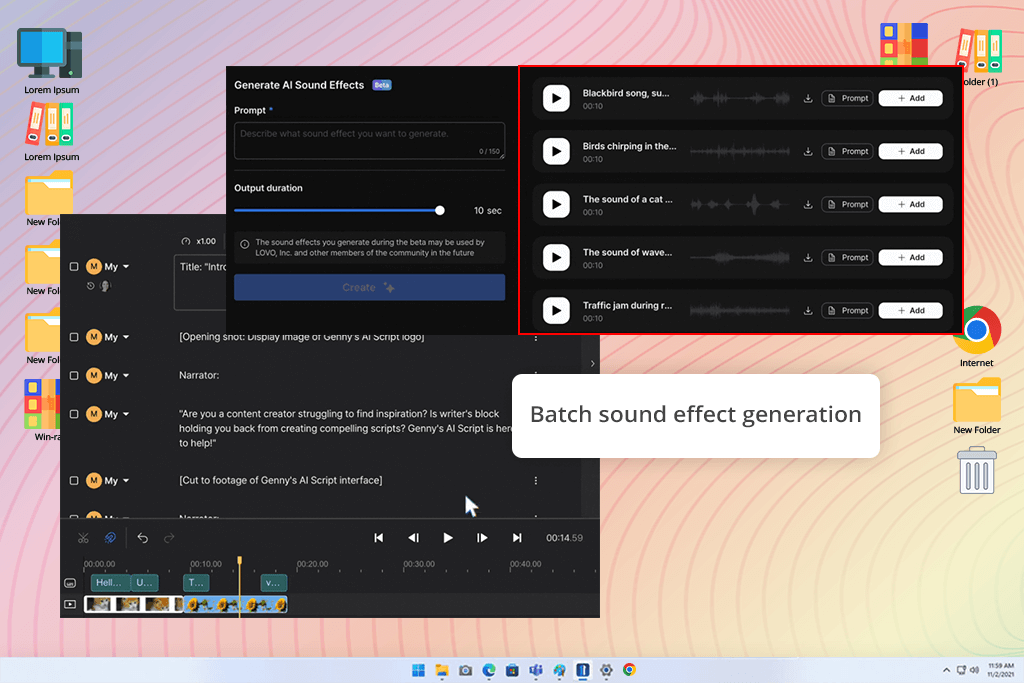

Ich habe Genny ausprobiert, als ich an einem 2D-Animationsprojekt mit mehreren kurzen Szenen arbeitete. Ich brauchte verschiedene Geräusche wie Schritte, sich öffnende Türen, Lachen und Stadtgeräusche, hatte aber keine Zeit, jedes Geräusch einzeln zu erstellen.

Gennys Batch-Funktion hat mich wirklich überrascht. Ich habe mehrere Eingabeaufforderungen gleichzeitig eingegeben, und es wurden in einem einzigen Durchgang zahlreiche Soundeffekte erzeugt. Alle Sounds passten gut zusammen und waren bereits ausgewogen und klar, was selten ist, wenn man Software für künstliche Intelligenz ohne zusätzliche Bearbeitung verwendet.

Es ist auf schnelles und reibungsloses Arbeiten ausgelegt. Der Wechsel zwischen verschiedenen Tonversionen ging fast blitzschnell, sodass ich Optionen testen konnte, ohne meinen Bearbeitungsprozess zu unterbrechen.

Genny ist nicht für aufwendige, detaillierte Tonbearbeitung gedacht, aber perfekt für Animatoren, YouTuber und kleinere Kreative, die innerhalb weniger Minuten viel hochwertiges Audiomaterial benötigen. Es ist benutzerfreundlich, zuverlässig und spart viel Zeit.

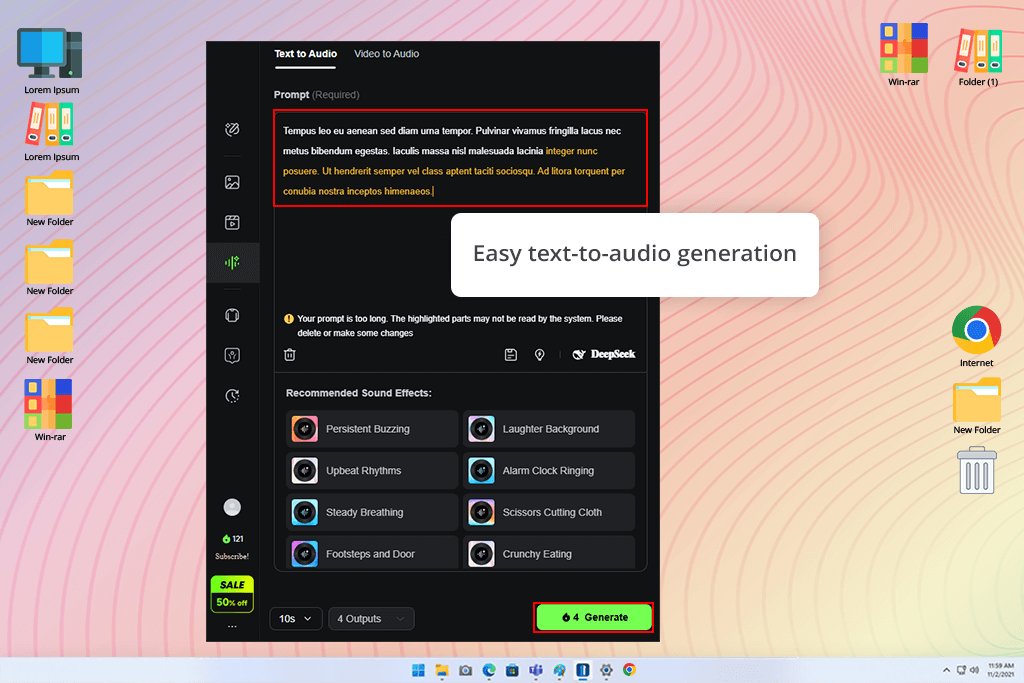

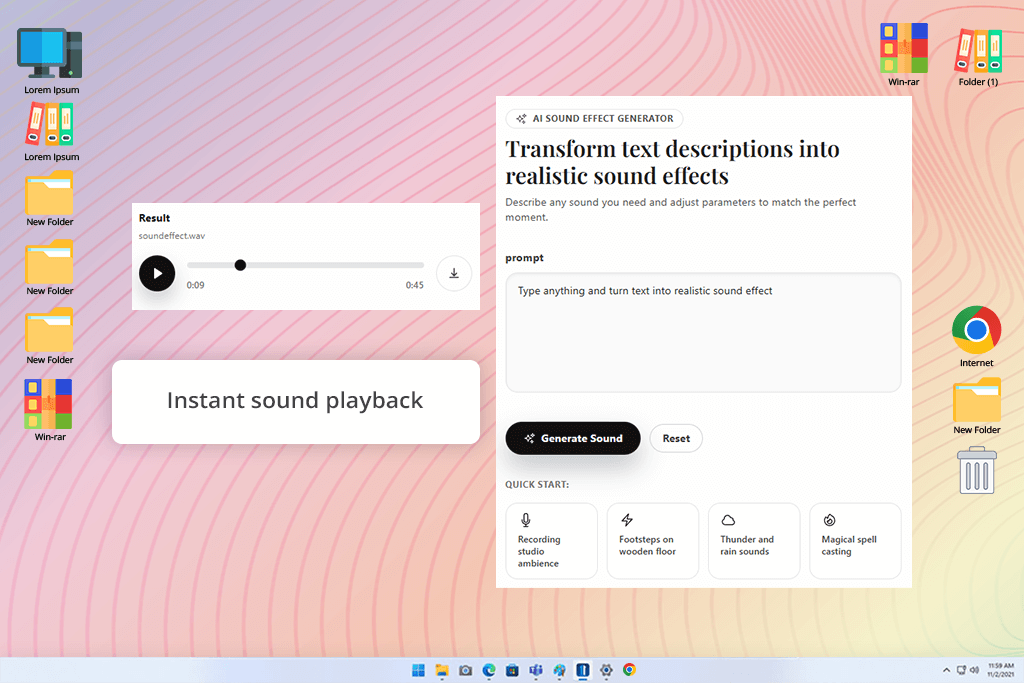

Dieser KI-Soundgenerator hat mich mehr beeindruckt als erwartet. Die Benutzeroberfläche ist intuitiv und konzentriert sich ausschließlich auf die Umwandlung von Text in Ton. Ich gab eine einfache Beschreibung ein, „Regen auf einem Metalldach mit leisem Donner in der Ferne“, und innerhalb weniger Sekunden wurde ein glaubwürdiger, brauchbarer Audioclip erstellt.

Am besten gefiel mir die einfache Bedienung – keine Installation, keine komplizierten Einstellungen. Es läuft direkt im Browser, sodass jeder sofort loslegen kann. Der Klang war klar und natürlich, mit guter Tiefe und ausgewogener Klangfarbe.

Es ist definitiv nicht für umfassendes Sounddesign oder komplexes Mischen gedacht – es richtet sich eher an Kreative, die schnell und unkompliziert Audio benötigen. Ich habe es letztendlich für schnelle Bearbeitungen, kurze Social-Media-Videos und temporäre Soundplatzhalter in größeren Projekten verwendet.

Es ist im Grunde der einfachste Weg, KI für Soundbearbeitung zu nutzen. Ideal für Anfänger oder alle, die schnelle Ergebnisse statt tiefgreifender Kontrolle wünschen. Und in Kombination mit einer DAW für Anfänger kann daraus ein überraschend leistungsstarkes Setup entstehen.

Bei FixThePhoto haben wir die beliebtesten KI-Soundeffekt-Tools getestet, um herauszufinden, welche tatsächlich so gut funktionieren wie beworben. Die Idee war einfach: Wir wollten herausfinden, ob diese Tools den Zeitaufwand für manuelles Sounddesign und -bearbeitung durch den Einsatz von KI zur effizienteren Audioerstellung realistisch reduzieren können.

Der Testprozess war eine Mischung aus technischer Prüfung und kreativer Beurteilung. Jedes Mitglied unseres Teams (Nataly Omelchenko, Tata Rossi und Kate Debela) testete die Tools aus seiner/ihrer eigenen beruflichen Perspektive.

Nataly, Spezialistin für Videobearbeitung und visuelles Storytelling, konzentrierte sich darauf, wie gut der KI-generierte Ton mit dem tatsächlichen Bildmaterial harmonierte. Sie lud verschiedene Clips hoch, darunter Reisesequenzen, Lifestyle-Aufnahmen und emotionale Kurzfilme, und beurteilte, ob die Töne zum Tempo, zur Stimmung und zur Handlung auf dem Bildschirm passten.

Tata legte Wert darauf, wie realistisch und ausgewogen die Klänge wirkten. Sie achtete darauf, wie die verschiedenen Ebenen zusammenwirkten, ob Lautstärke und Klangfarbe natürlich klangen und ob sich der Ton ohne größere Nachbearbeitung in das Video einfügte. Außerdem notierte sie, welche Werkzeuge sich besser für die Erzeugung einer allgemeinen Hintergrundatmosphäre eigneten und welche für präzise, detaillierte Soundeffekte nützlicher waren.

Kate hingegen konzentrierte sich auf die Benutzerfreundlichkeit der Tools. Sie prüfte, wie schnell die einzelnen KI-Audio-Tools KI-Audio-Tools Töne erzeugten, ob die Bedienung intuitiv war und wie reibungslos sich die Töne in Videobearbeitungsprogramme integrieren ließen. Außerdem untersuchte sie, wie gut die Tools für Anfänger ohne Erfahrung im Sounddesign geeignet sind.

Wir haben gemeinsam jeden KI-Soundgenerator in realen, alltäglichen Bearbeitungssituationen getestet. Wir verwendeten dieselben Videoclips (von ruhigen Straßenszenen bis hin zu rasanten, actionreichen Aufnahmen) und verglichen, wie die einzelnen Tools auf dieselbe Beschreibung oder Stimmung reagierten. Einige Generatoren beeindruckten uns mit einem satten, vielschichtigen, filmischen Klang, während andere vor allem durch ihre Geschwindigkeit und Benutzerfreundlichkeit punkteten.

Während der Tests bewerteten wir nicht nur die Klangqualität des finalen Audios. Wir untersuchten auch, wie einfach sich die einzelnen Tools in den gewohnten Workflow eines Kreativen integrieren ließen. Die Unterschiede waren deutlich: Firefly fügte sich nahtlos in andere Adobe-Programme ein, ElevenLabs erzeugte unglaublich lebensechte Stimmen, die SFX Engine ermöglichte eine sehr präzise Klangsteuerung, während Canva auf schnelle und einfache Klangerstellung mit minimalem Aufwand ausgelegt war.

Nach Abschluss unserer Tests war klar, dass es kein perfektes KI-Tool für jede Situation gibt – jedes eignet sich am besten für unterschiedliche Bedürfnisse. Besonders beeindruckend war die rasante Entwicklung der KI-Audiobearbeitung. Die Ergebnisse wirkten oft überraschend natürlich und kreativ, und wir sind gespannt, wie sich diese Tools in Zukunft weiterentwickeln werden.