Сканер веб-сайтов - это программа, используемая для сканирования сайтов, считывания контента (и другой информации) с целью создания записей для индекса поисковой системы.

Все поисковые системы используют сканеры веб-сайтов (также известные как паук или бот). Использование данных программ позволяет вам увидеть, как нужно оптимизировать ваш контент, и какие проблемы исправить, чтобы улучшить SEO-рейтинг вашего сайта.

В приведенном ниже списке содержится как программное обеспечение с открытым исходным кодом (бесплатное), так и коммерческое (платное). Кроме стоимости при подборе программа я учитывала такие особенности, как масштабируемость/ограничение использования, скорость работы клиентской поддержки и качество данных.

Чтобы вам не пришлось самостоятельно очищать данные, вы можете выбрать инструмент для сканирования, интегрированный с функциями очистки данных.

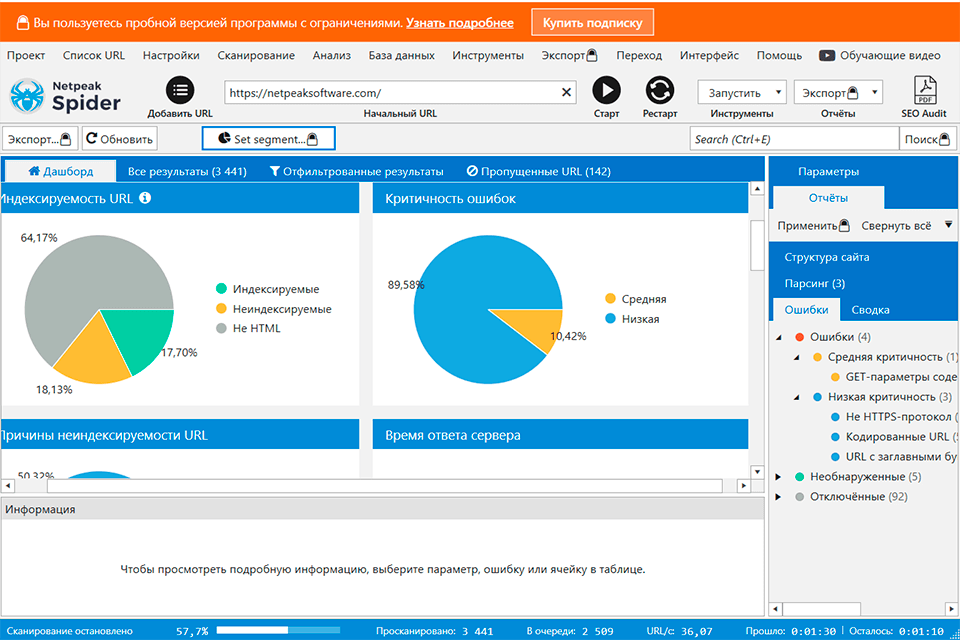

Вердикт: Netpeak Spider сканирует веб-сайты, чтобы отыскать проблемы SEO-оптимизации. С помощью этого софта вы сможете проверить 100+ основных SEO-параметров, определить 80+ ключевых ошибок внутренней оптимизации и определить дублирование параметров контента.

Программа интегрируется с Google Analytics и Search Console.

Netpeak Spider позволяет проверить сайт, а также соизировать ваш контент, и какие проббрать любые данные с веб-страниц: цены, отзывы, SEO-тексты, наличие каких-то уникальных тегов, даты публикации статей и прочее. В результате вы получите продвинутую таблицу данных с опциями, сортировки, быстрый поиск и прочими.

Кроме того, в программе есть несколько дополнительных инструментов, таких как анализ исходного кода и HTTP-заголовков, расчёт PageRank, валидатор и генератор Sitemap.

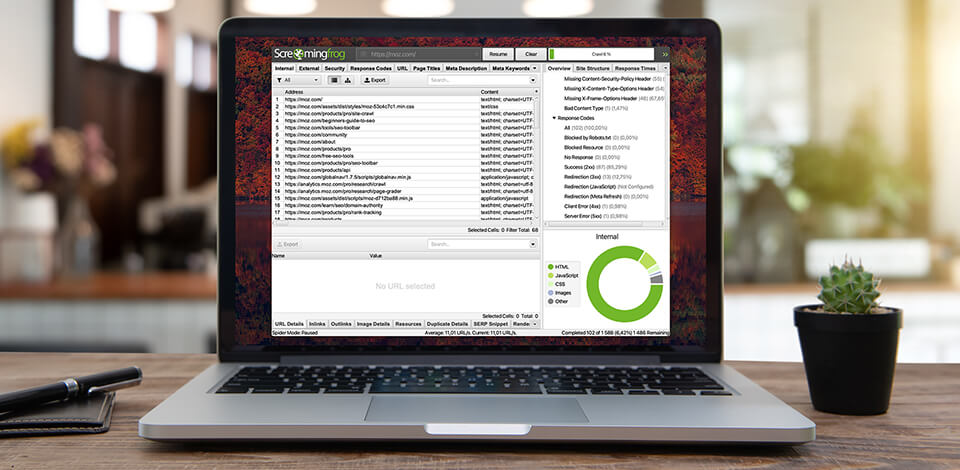

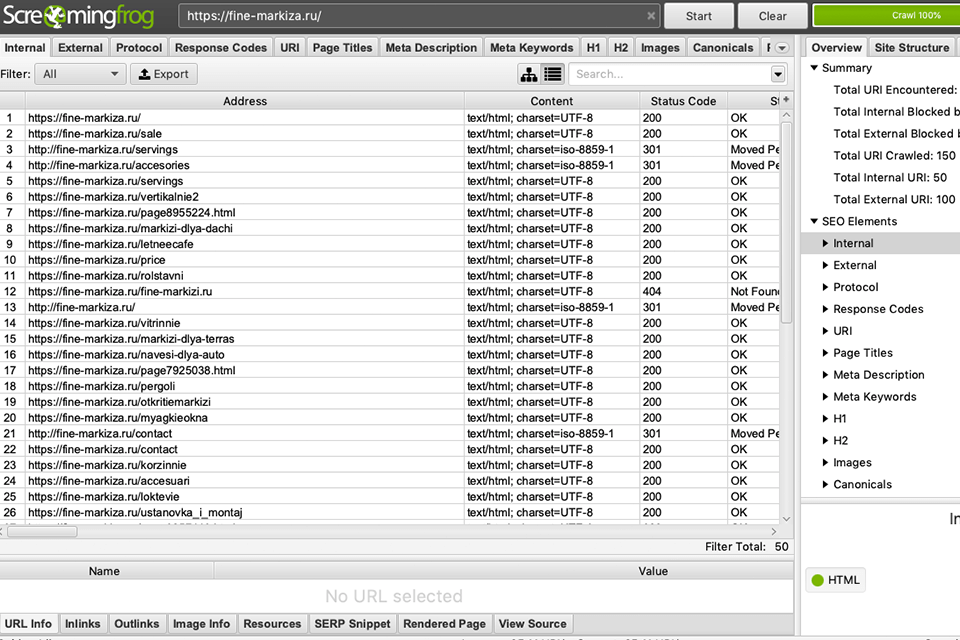

Вердикт: Screaming Frog помогает вам анализировать и проверять технический и локальный SEO. Вы можете использовать этот инструмент для бесплатного сканирования до 500 URL. Он мгновенно находит битые ссылки и ошибки сервера, а также помогает проанализировать заголовки страниц и метаданные.

Он позволяет интегрироваться с Google Analytics, GSC (Google Search Console) и PSI (PageSpeed Insights). Эта SEO программа помогает вам находить повторяющийся контент и создавать XML-файлы Sitemap. А после сканирования для каждого URL-адреса вы увидите важную информацию, такую как возвращенный код состояния, заголовок страницы, мета-описание, содержимое H1, содержимое H2 и количество слов.

Кроме того, здесь есть вкладка Заголовки страниц, которая включает в себя информацию о заголовках, найденных по каждому URL, такую как количество заголовков на странице и длину символа каждого заголовка.

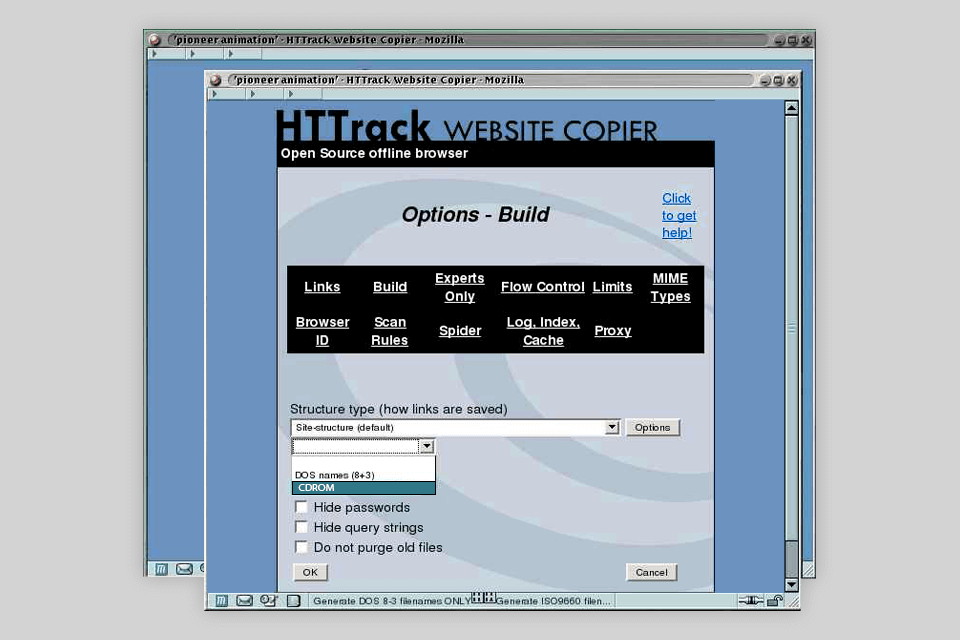

Вердикт: HTTrack - это впечатляющий продукт, который делает все, что вы можете захотеть от рипера веб-сайтов - позволяет загрузить любой веб-сайт на свой компьютер, а затем просматривать его в удобное для вас время. Он скачивает весь веб-сайт: подкаталоги, изображения и внутренние ссылки. Ссылки на внешние веб-сайты активны только при наличии подключения к Интернету.

HTTrack совместим со всеми версиями Windows и распространяется под лицензией GPL. HTTrack также может обновлять существующий зеркальный сайт и возобновлять прерванные загрузки. HTTrack полностью настраивается и имеет встроенную справочную систему. После быстрой установки вы можете запустить программу и выбрать предпочтительный язык.

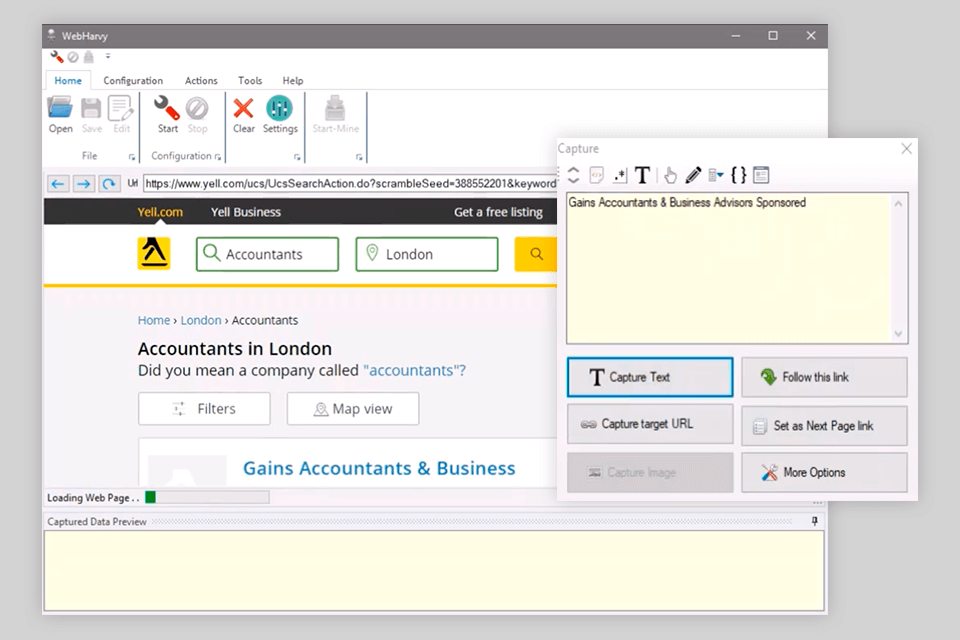

Вердикт: WebHarvy может автоматически очищать текст, изображения, URL-адреса и электронные письма с веб-сайтов и сохранять извлеченный контент в различных форматах. Он также предоставляет встроенный планировщик и поддержку прокси.

Инструмент работает по аналогии с VPN для дома. Вы сможете анонимно сканировать и предотвращать блокировку программного обеспечения для парсинга веб-серверами. Вы можете извлекать данные из более чем одной страницы, ключевых слов и категорий.

Эта программа позволяет экспортировать очищенные данные в виде файла XML, CSV, JSON или TSV. Пользователь также может экспортировать очищенные данные в базу данных SQL. Кроме того, он помогает запускать код JavaScript в браузере.

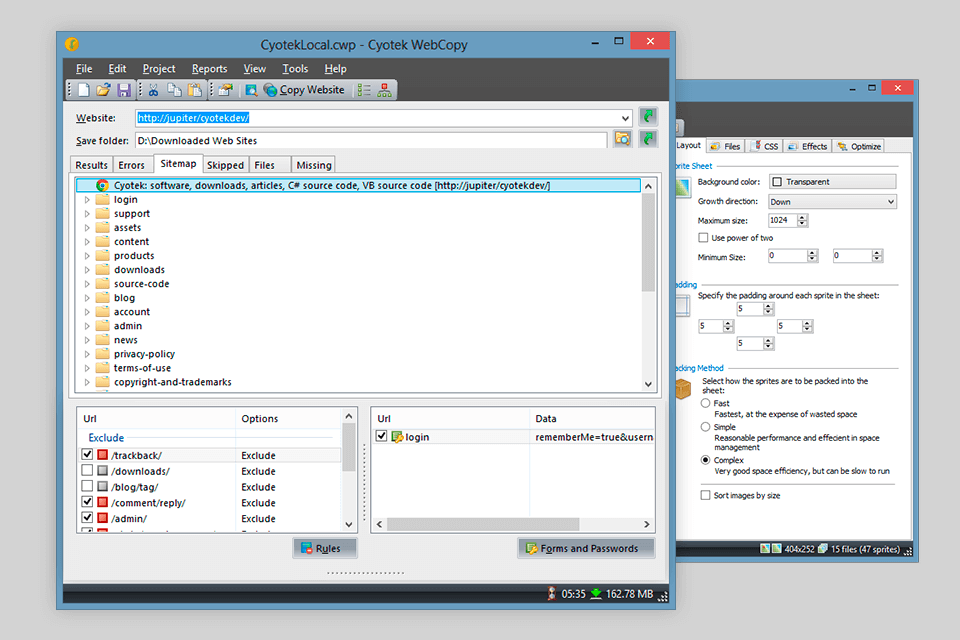

Вердикт: Cyotek WebCopy - это бесплатный инструмент для локального копирования целых или частей веб-сайтов на жесткий диск для просмотра в автономном режиме. Пользовательский интерфейс WebCopy не сложен, а сам инструмент несложно использовать, не обращаясь к многочисленным ресурсам меню «Справка».

Он исследует структуру веб-сайтов, а также связанные ресурсы, включая таблицы, изображения, видео и многое другое. И этот связанный ресурс будет автоматически переназначен, чтобы соответствовать его локальному пути.

Обратной стороной является то, что Cyotek WebCopy не может анализировать/сканировать/извлекать веб-сайты, которые применяют Javascript.

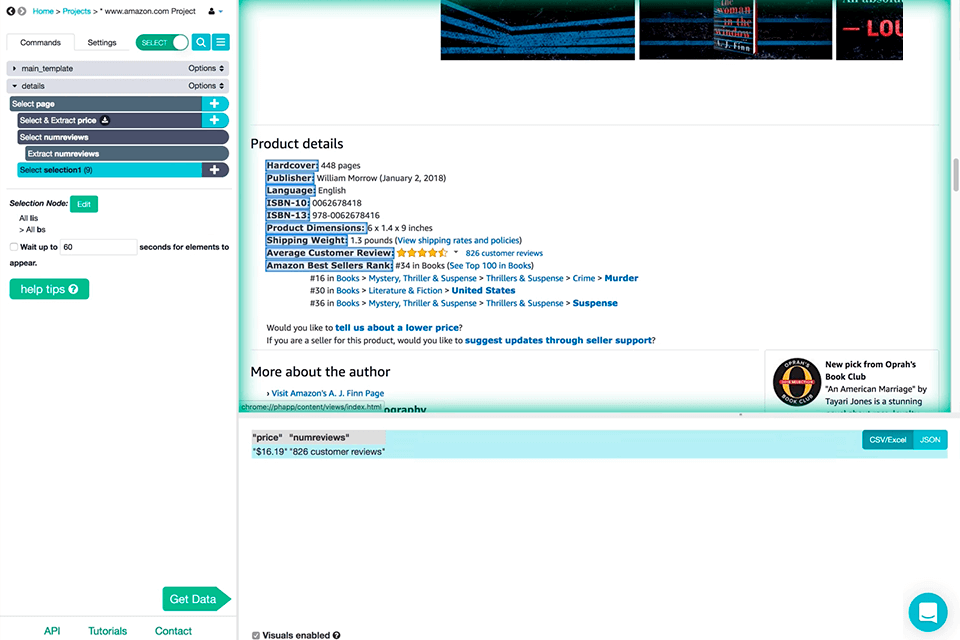

Вердикт: Parsehub - это многоцелевой визуальный инструмент для сканирования сайта с интуитивно понятным интерфейсом и процессами, которые выполняются в облаке. Он поддерживает сбор данных с веб-сайтов, которые используют технологии AJAX, JavaScript, файлы cookie и т.д.

Его технология машинного обучения может читать, анализировать и затем преобразовывать веб-документы в соответствующие данные. Инструменты могут легко заполнять формы, входить на веб-сайты, работать с интерактивными картами, календарями и даже сайтами с бесконечной прокруткой.

Инструмент способен извлекать необходимую информацию из любого места на странице. Настольное приложение ParseHub поддерживает такие системы, как Windows, Mac OS X и Linux. Вы даже можете использовать веб-приложение, встроенное в браузер.

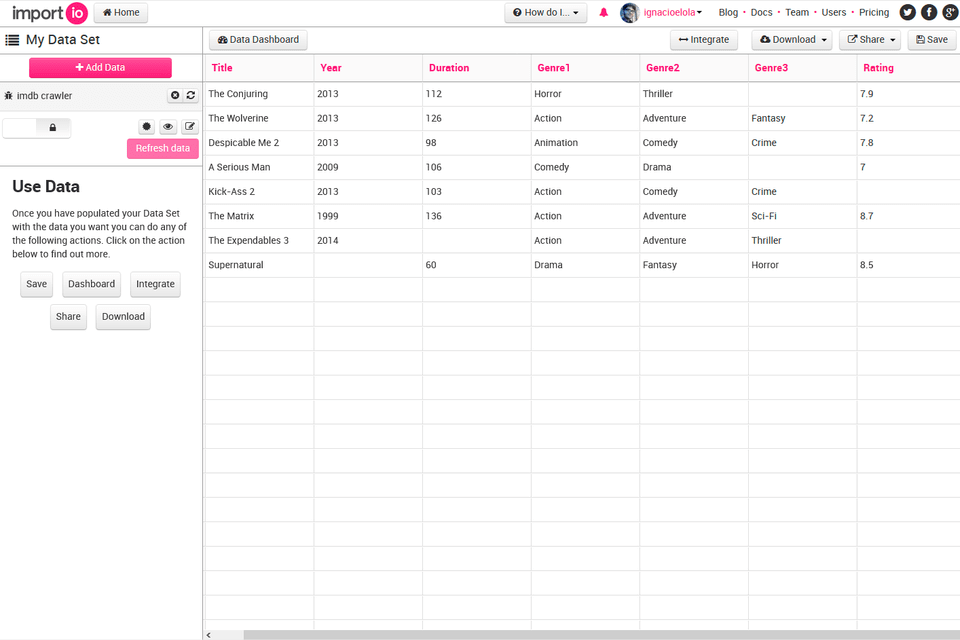

Вердикт: С Import.io вы можете легко очистить тысячи веб-страниц за считанные минуты, не написав ни единой строчки кода, и создать более 1000 API-интерфейсов в соответствии с вашими требованиями.

Этот инструмент упростил сканирование за счет интеграции веб-данных в ваше собственное приложение или веб-сайт всего за несколько кликов. Кроме того, пользователи могут планировать задачи сканирования еженедельно, ежедневно или ежечасно.

Вместе с веб-инструментом доступны бесплатные приложения для Windows, Mac OS X и Linux для создания экстракторов данных и поисковых роботов, которые обеспечивают загрузку данных и синхронизацию с учетной записью онлайн. Программа интегрируется со многими распространенными языками программирования и инструментами анализа данных.

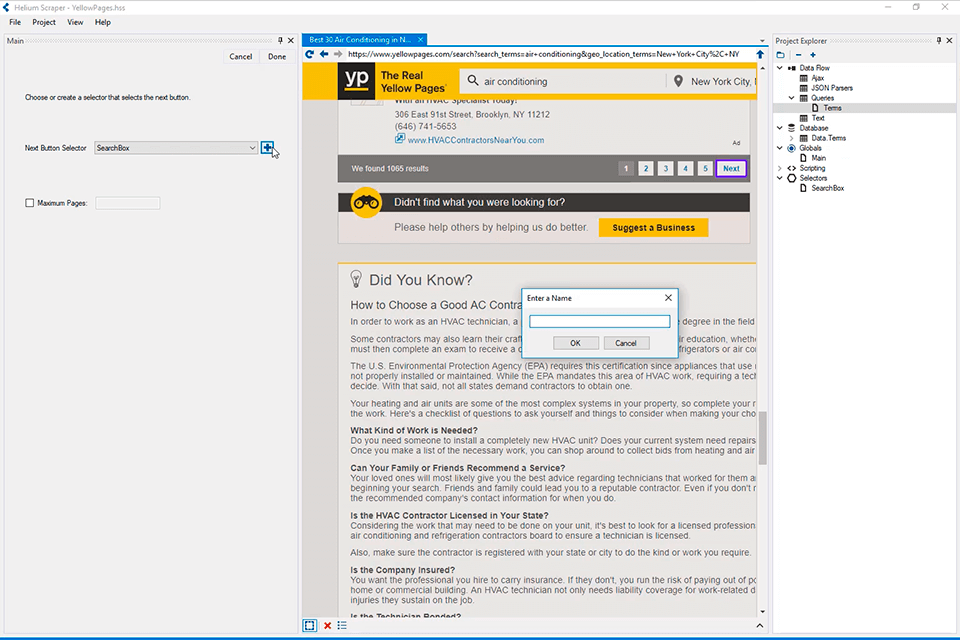

Вердикт: Helium Scraper позволяет выбрать, что извлекать, а что нет, всего за несколько кликов. Это все благодаря режиму активированного выбора. Все, что для этого требуется, - это установить пару похожих образцов, а программное обеспечение обработает все остальное, выделяя точные реплики элементов по мере необходимости.

Пользователи могут получить доступ к онлайн-шаблонам для различных нужд сканирования. Можно извлечь до 100 записей. Причем экспортировать данные можно в самые разные форматы файлов.

Создавать файлы базы данных CSV или MDB Access можно одним нажатием кнопки. Результаты можно просматривать, извлекать и заносить в таблицы.

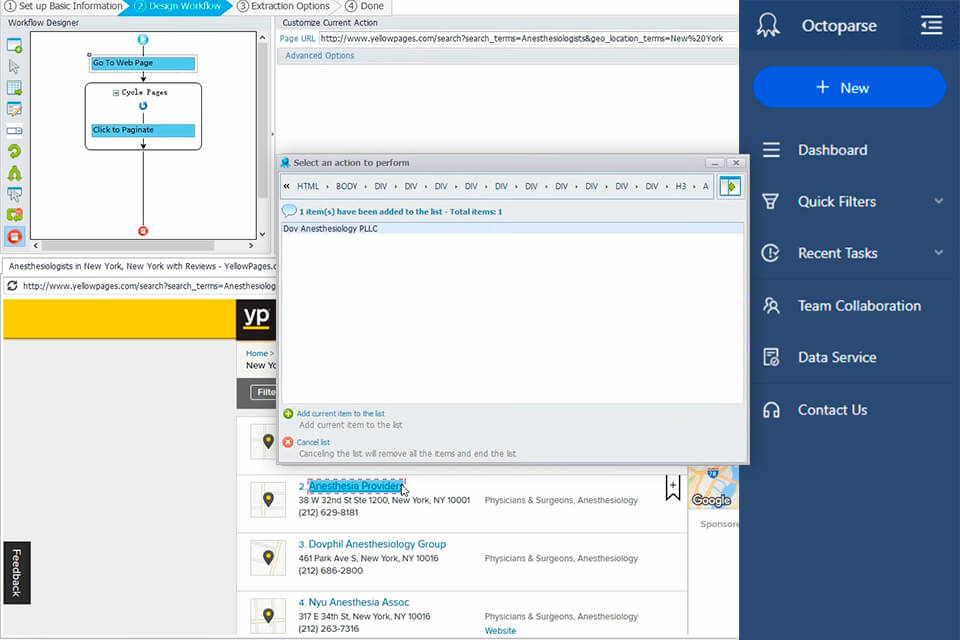

Вердикт: Octoparse - это облачное решение для извлечения веб-данных, которое помогает пользователям извлекать релевантную информацию с различных типов веб-сайтов. Оно позволяет пользователям из самых разных отраслей получать неструктурированные данные и сохранять их в различных форматах, включая Excel, обычный текст и HTML.

Пользователи могут щелкнуть элемент на веб-странице, чтобы выбрать тип данных для извлечения. Octoparse позволяет пользователям одновременно запускать несколько задач извлечения. Задачи можно планировать для выполнения через регулярные промежутки времени или в режиме реального времени.

Пользователи также могут собирать комментарии и обзоры продуктов и каналы социальных сетей для сбора информации о настроениях потребителей. Режим wizard предоставляет пользователям пошаговые инструкции по извлечению данных.

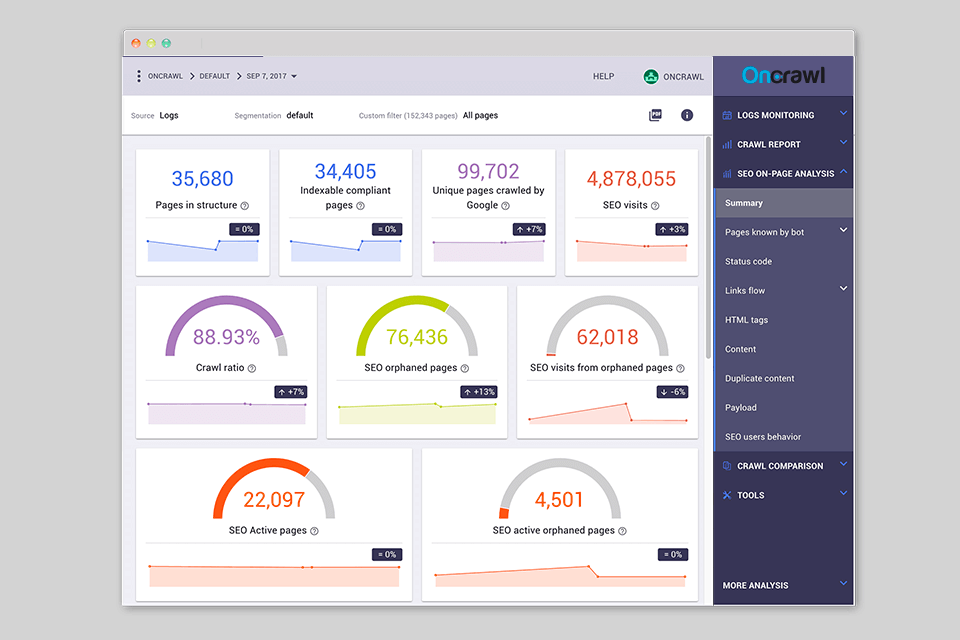

Вердикт: OnCrawl находит все факторы, которые блокируют индексацию ваших веб-страниц. Вы можете импортировать HTML, контент и архитектуру для сканирования страниц вашего сайта.

Кроме того, эта программа позволяет обнаруживать дублированный контент на любом сайте. OnCrawl может сканировать веб-сайт с помощью кода JavaScript. Вы можете выбрать два сканирования для сравнения и измерения влияния новых политик на ваш сайт.

По окончании сканирования у вас будет сводная вкладка с информацией о том, сколько страниц было просканировано, проиндексировано или без индекса и надоедливые ошибки, которые могут повредить вашему ранжированию. Также вы можете узнать информацию о заголовке, коде статуса и мета-роботах, кликнув на определенную диаграмму.

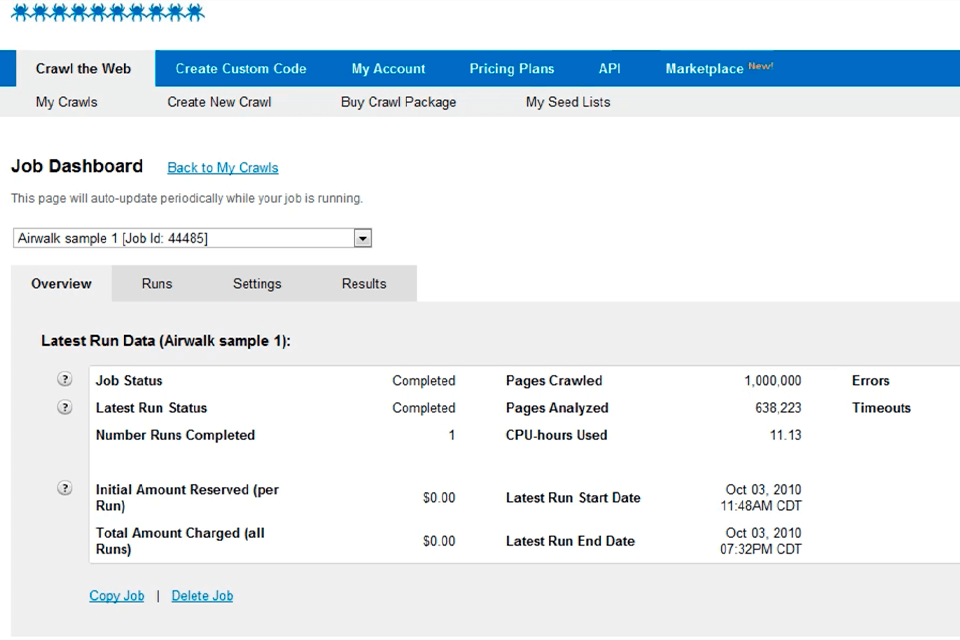

Вердикт: 80legs предлагает сервис сканирования, который позволяет пользователям легко составлять задания сканирования и выполнять их в облаке в распределенной компьютерной сети. 80legs делает технологию веб-сканирования более доступной для небольших компаний и частных лиц, предоставляя арендованный доступ и позволяя клиентам платить только за то, что они сканируют.

Поэтому этот веб-сервис лучше всего подходит для стартапов, малых и средних предприятий, которые хотят сканировать данные только по бюджетным ценам. Теперь нетехнические пользователи могут настроить задания сканирования с адаптивным управлением. Разработчики, в свою очередь, могут включать API 80legs в свои приложения, чтобы распространять поисковую сеть.

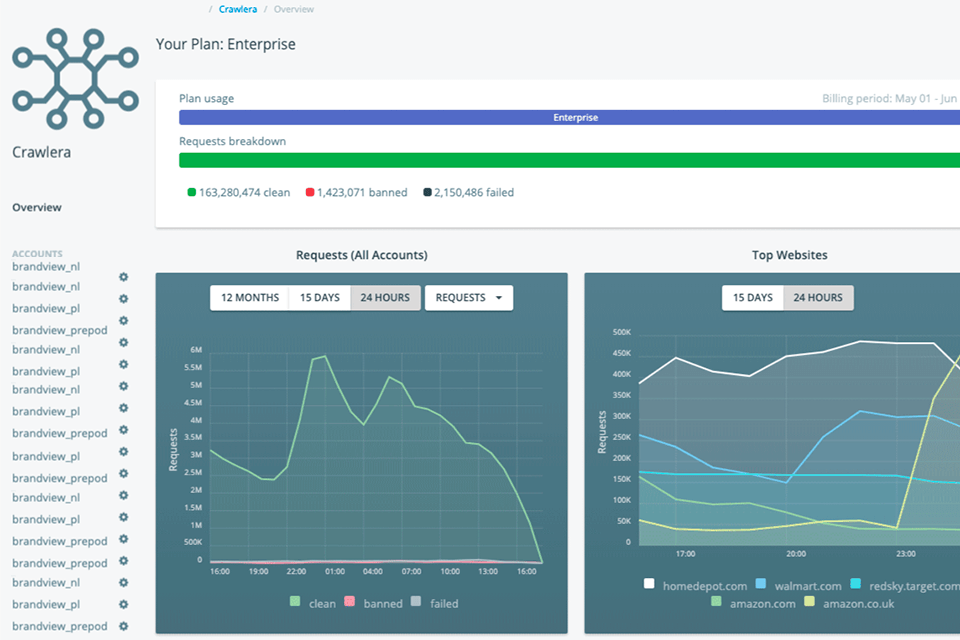

Вердикт: Zyte одна из лучших платформ для очистки данных, основана на языке программирования Python. Она состоит из 4 отличных инструментов: Scrapy Cloud, Portia, Crawlera, Splash. Следующее, что стоит упомянуть, это то, что, хотя инструмент ориентирован на разработчиков, вам не обязательно иметь опыт работы в этой области, чтобы использовать его или что-либо кодировать.

Именно поэтому это одно из лучших решений практически для любого веб-сайта. У Scrapinghub хорошие и гибкие цены. У компаний есть два основных варианта: самостоятельно искать данные, подписавшись на ежемесячный план, или получить помощь от команды Scrapinghub.

Если вы предпочитаете работать самостоятельно, это обойдется вам дешевле, но займет больше времени. Если вы позволите Scrapinghub заниматься вашим проектом, это будет дороже, но вам не придется с этим возиться. Лучший аспект обслуживания - это отзывчивый и дружелюбный квалифицированный персонал.

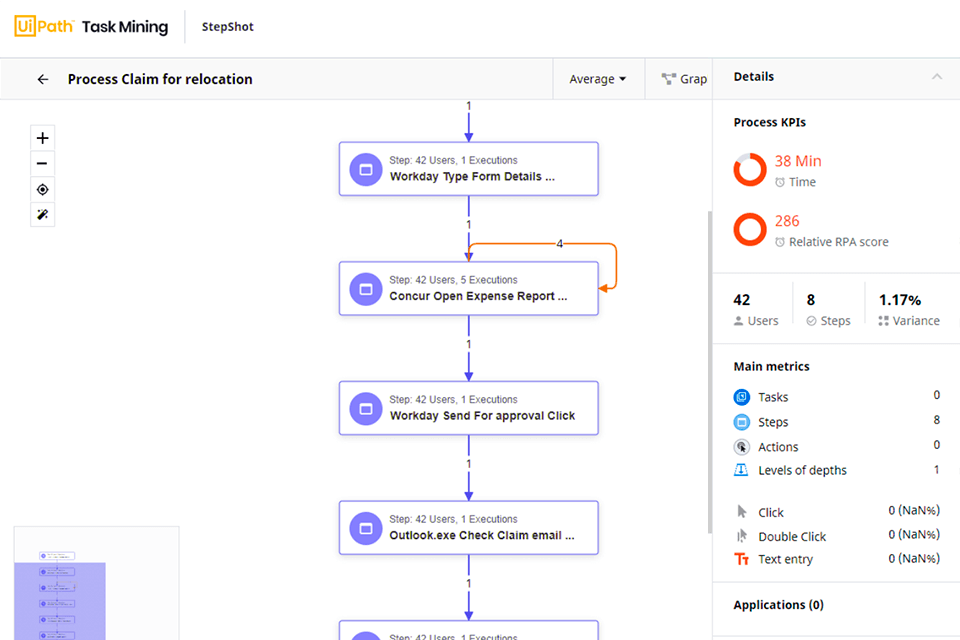

Вердикт: UiPath автоматизирует сканирование данных из Интернета и настольных компьютеров из большинства сторонних приложений. Он может извлекать табличные данные и данные на основе шаблонов на нескольких веб-страницах. UiPath также имеет встроенную библиотеку шаблонов, которая предоставляет пользователям настраиваемые шаблоны для общих процессов.

Продукт также поддерживает как настольные компьютеры, так и приложения, доступные через Citrix. Программное обеспечение предоставляет встроенные инструменты для дальнейшего сканирования. Инструмент очистки экрана может обрабатывать как отдельные текстовые элементы, так и группы текста, а также блоки текста, например извлечение данных в формате таблицы.

UiPath размещает платформу Studio Community, где как команды, так и отдельные разработчики могут получить доступ к онлайн-учебным материалам и совместно решать проблемы, связанные с программным обеспечением.

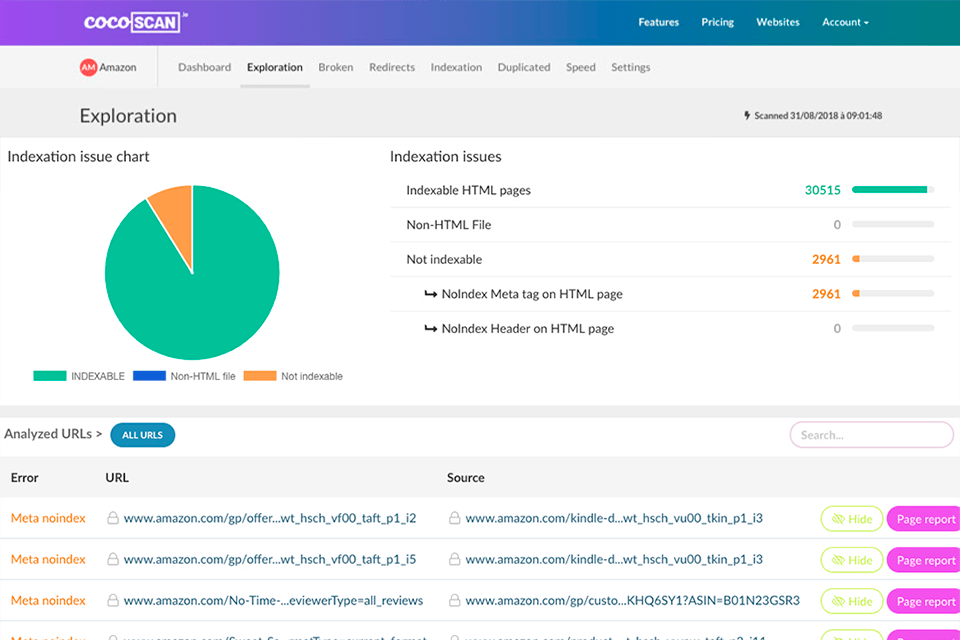

Вердикт: Cocoscan может проверять наличие дублированного письменного контента на любом веб-сайте и определять плотность важных ключевых слов. Этот инструмент может проанализировать ваш веб-сайт и сделать его доступным для поиска в поисковой системе. Также он предлагает визуальное изображение адаптивного веб-сайта в реальном времени.

Он предоставляет вам список страниц с проблемами, которые могут повлиять на ваш сайт. Что еще лучше, так это то, что вы можете исправлять эти ошибки одну за другой и повторно сканировать страницу за страницей, вместо того, чтобы повторно сканировать весь сайт.

Вы можете получить доступ к сканированию в режиме реального времени во время анализа, поэтому вам не придется ждать несколько дней, чтобы получить результаты.

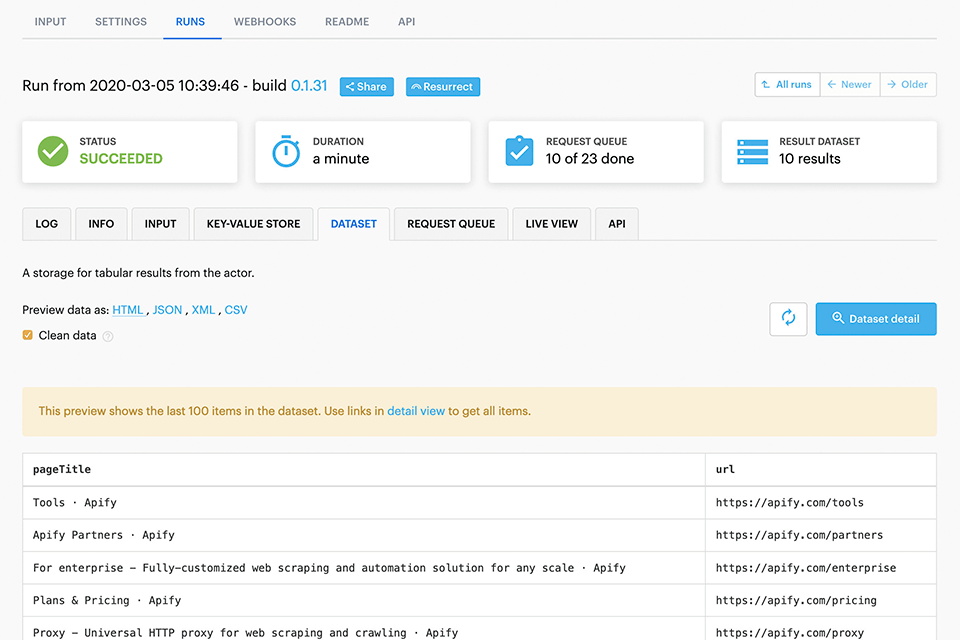

Вердикт: Apify сканирует списки URL-адресов и автоматизирует рабочие процессы. Масштабируемая библиотека парсинга позволяет разрабатывать задания по извлечению данных и веб-автоматизации с помощью Chrome и Puppeteer.

С помощью таких инструментов, как RequestQueue и AutoscaledPool, вы можете начать с нескольких URL-адресов и рекурсивно переходить по ссылкам на другие страницы, а также запускать задачи очистки с максимальной мощностью системы соответственно.

Этот инструмент автоматически поддерживает очереди URL-адресов для сканирования. Программа позволяет выполнить масштабирование с высокой производительностью. А также вы сможете использовать Apify Cloud с прокси, чтобы избежать обнаружения.

Вердикт: Scraper - это надежный сервис, который позволяет извлечь любую веб-страницу HTML и загружать их в Google Таблицы или Microsoft Excel. С помощью Scraper вы можете экспортировать веб-страницы в файлы XLS, CSV, XLSX или TSV (.xls .csv .xlsx .tsv).

Используя один из тысяч шаблонов парсинга, вы можете конвертировать большинство популярных веб-сайтов в CSV всего одним щелчком мыши. Шаблоны создаются пользователями и передаются другим пользователям. У них есть более 50 000 шаблонов для более чем 10 000 лучших сайтов мира.

Платный план подписки нужен только пользователям с большим объемом работы, для всех остальных - расширение абсолютно бесплатно. Оно может не предлагать комплексные услуги сканирования, но новичкам также не нужно разбираться в сложных настройками.